Entropie und Grundlagen Statistischer Physik

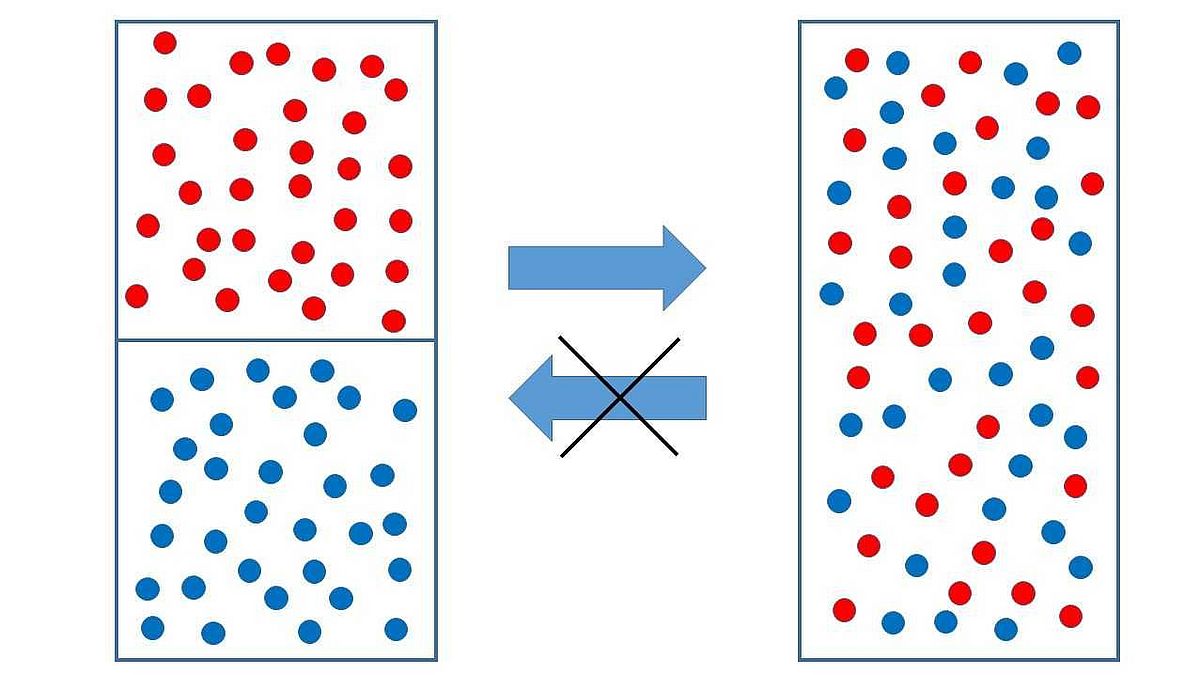

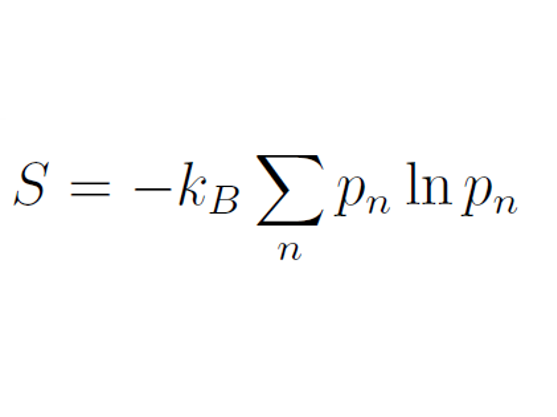

Die Entropie ist eine fundamentale thermodynamische Zustandsgröße. Sie ist extensiv, d.h. sie ist additiv bei Vereinigung mehrerer Systeme wie auch das Volumen, die Teilchenzahl oder die (innere) Energie. Die in einem System vorhandene Entropie steigt bei Aufnahme und sinkt bei Abgabe von Wärme oder steigt durch spontan ablaufende Prozesse innerhalb des Systems wie z. B. Vermischung, Wärmeleitung, u.ä.. In einem abgeschlossenen System kann die Entropie im Laufe der Zeit nur zunehmen (Zweiter Hauptsatz der Thermodynamik). Prozesse, bei denen Entropie entsteht, sind irreversibel. Man sagt auch, Entropie sei ein Maß für die Unordnung eines Systems, dann entspricht die Aussage über die Entropie-Zunahme in einem sich selbst überlassenen System der Alltagserfahrung (der Unordnungszunahme auf dem Schreibtisch, in der Küche etc., wenn man nicht eingreift). Aber wie ist Entropie genau (mathematisch exakt) zu definieren? Während Entropie in der klassischen Thermodynamik eher eine phänomenologische Größe ist, kann man in der Statistischen Physik eine präzise Definition geben. Danach ist die Entropie ein Maß für die Zahl der möglichen Mikrozustände, die zum gleichen Makrozustand eines thermodynamischen Systems aus sehr vielen Teilchen (oder mit sehr vielen Freiheitsgraden) führt. Wenn es mehrere Mikrozustände n gibt, die mit Wahrscheinlichkeit pn angenommen werden können (d.h. mit dieser Wahrscheinlichkeit zum Makrozustand beitragen), ist die Entropie definiert als (Formel siehe rechte Seite):

Dabei ist kB die Boltzmann-Konstante. Liegt mit Sicherheit ein bestimmter Zustand vor, ist die Wahrscheinlichkeit dafür 1 und die für alle anderen Zustände 0 und die Entropie wird ebenfalls 0. Daher verschwindet die Entropie in der Regel bei der Temperatur T = 0 K, d.h. am absoluten Nullpunkt der Temperatur, wenn ein System mit Sicherheit im Grundzustand ist (3. Hauptsatz der Wärmelehre oder Nernstsches Theorem). Bei allen endlichen Temperaturen T > 0 K können aber mehrere Zustände angenommen werden und die Entropie gemäß obiger Definition ist positiv.

Im Vortrag werden die Grundideen der Statistischen Physik dargelegt, woraus dann die oben angegebene Definition der Entropie verständlich werden sollte. Für einfache Systeme wie das klassische ideale Gas werden auch explizite Gleichungen für die Entropie hergeleitet, die auch auf Schul-Niveau schon eingeführt werden können. Mit Hilfe dieser Gleichungen kann man explizit nachrechnen, dass die Entropie bei irreversiblen Prozessen zunimmt. Dazu wird die Mischungsentropie, z.B. bei der Mischung zweier (unterscheidbarer) Gase oder bei der Mischung zweier Flüssigkeiten verschiedener Temperatur, explizit berechnet.

Der Begriff „Entropie“ wird inzwischen auch über die Physik hinaus benutzt, etwa in der Informatik (Shannon-Entropie, „Entropie ist fehlende Information“) oder in den Sozialwissenschaften („soziale Unordnung“). Auch darauf soll im Vortrag zum Schluss noch eingegangen werden.

Ablauf

Die Veranstaltung am 29.01.2019 findet im Raum S1260 im Gebäude NW1 statt. Treffpunkt ist jedoch um 17 Uhr in der Eingangshalle.

17.05 Uhr | Vortrag |

| 18.00 Uhr | Pause, Zeit für Gespräche und ein kleiner Imbiss |

| 18.30 Uhr | Gesprächskreis für alle, die noch Fragen haben oder weiter über das Thema diskutieren möchten. |

| 19.00 Uhr | Ende |

Download: Lageplan ZARM (Zentrum für angewandte Raumfahrttechnologie und Mikrogravitation)

Zum Vortragenden:

Prof. Dr. Gerd Czycholl ist Wissenschaftler im Institut für Theoretische Physik der Universität Bremen. Dort leitet er die Arbeitsgruppe "Solid-State Theory".